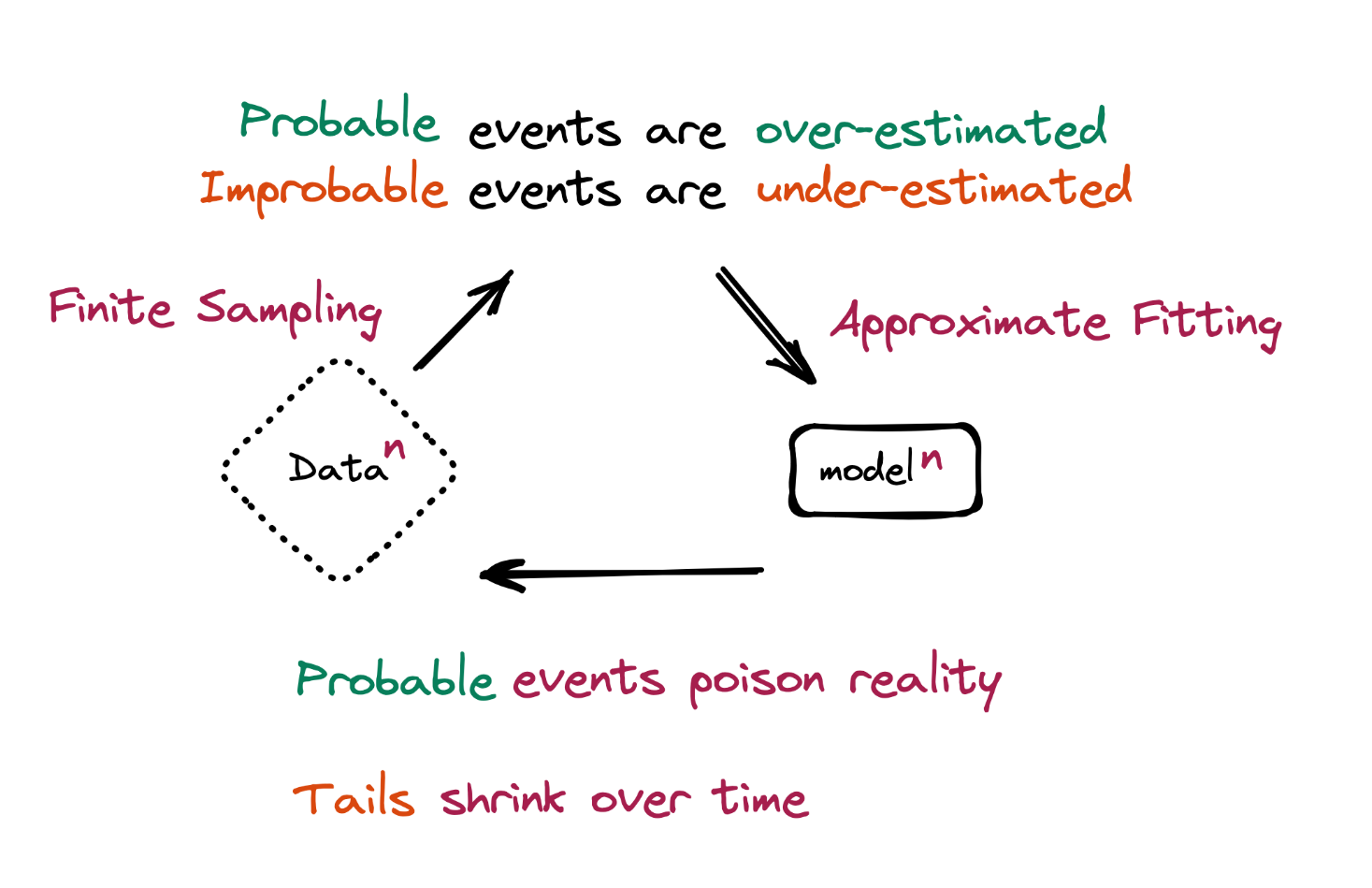

Группа исследователей из Кембриджского и Оксфордского университетов, Университета Торонто и Имперского колледжа в Лондоне в исследовательской работе наблюдал за сценариями, когда большие лингвистические модели (LLM) учатся или доучиваются на данных, сгенерированных тоже ИИ. В документе под названием «Проклятие рекурсии: обучение на сгенерированных данных заставляет модели забывать» описывается дегенеративный процесс, называемый «коллапсом модели», когда модель отрывается от реальности и искажается собственными выводами.

Это не удивительно. Информация, генерируемая моделями представляет собой результат статистических вычислений. Во время этих вычислений модель стремится минимизировать погрешность. То есть сделать результат как можно более точным относительно собственному пониманию правды и фактов. Этот результат обязательно несёт в себе долю погрешности в большинстве случаев. Вы можете попросить модель сгенерировать фунцию для расчёта числа фибоначи и она не ошибётся в генерации, потому что уровень погрешности здесь сведён к 0 за счёт того, что модель видела много примеров такой функции на этапе своего обучения - и все эти примеры были точными. Но при генерации более абстрактных выводов или выводов о не до конца понятных феноменах, погрешность неизбежна.

Comments